论文阅读_ResNet

基本信息

| 项目 | 内容 |

|---|---|

| 论文标题 | Deep Residual Learning for Image Recognition |

| 作者 | Kaiming He(何恺明)、Xiangyu Zhang、Shaoqing Ren、Jian Sun(微软亚洲研究院) |

| 作者单位 | 微软亚洲研究院 |

| 时间 | 2016 |

| 发表会议/期刊 |

方法概览

| 特点 | 文章性质 |

|---|---|

| 输入 | 单张 RGB 图像 |

| 输出 | 分类、分割 |

| 所属领域 | 视觉 Transformer |

创新点

- 网络越深,性能越好当网络超过一定深度(如 20 层以上),继续加深反而导致性能下降,这被称为 网络退化(Degradation Problem)。梯度在反向传播时逐层衰减,提出 残差学习(Residual Learning) 和 跳跃连接(Skip Connection),解决了深度网络训练难题。

- 残差结果

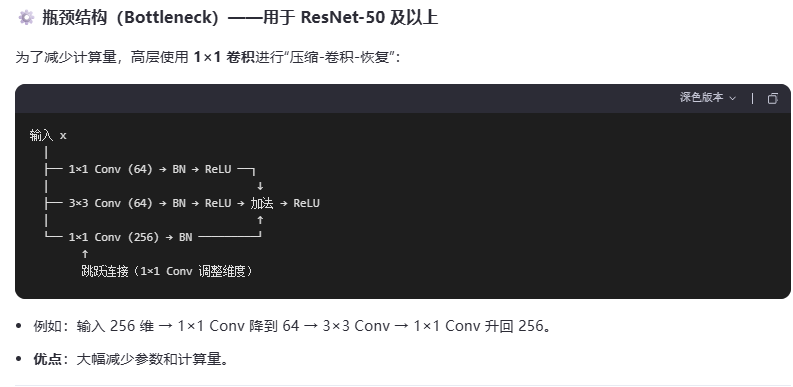

- 瓶颈结构(Bottleneck)用于 ResNet-50 及以上

- Batch Normalization(BN) 是 ResNet 成功的关键组成部分之一,它与 残差连接 一起,共同解决了深度网络训练中的 梯度消失/爆炸 和 内部协变量偏移(Internal Covariate Shift) 问题。

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来源 This is a 部落格 of outbreak_sen!