论文阅读_SpatialTracker

基本信息

| 项目 | 内容 |

|---|---|

| 论文标题 | SpatialTracker: Tracking Any 2D Pixels in 3D Space |

| 作者 | Yuxi Xiao1,3* Qianqian Wang2* Shangzhan Zhang1,3 Nan Xue3 Sida Peng彭斯达1 Yujun Shen3 Xiaowei Zhou1†周晓魏 ∗:平等贡献;†:项目负责人;‡:通讯作者。 |

| 作者单位 | 浙江大学 UC伯克利 蚂蚁集团 |

| 时间 | 2024axiv |

| 发表会议/期刊 |

方法概览

| 特点 | 文章性质 |

|---|---|

| 输入 | 单目视频 |

| 输出 | 3D 点轨迹 |

| 所属领域 | 点跟踪 |

| 一句话总结做了什么 | 跟踪 3D 空间中的 2D 像素。为了估计遮挡和复杂 3D 运动下的 2D 运动,将 2D 像素提升到 3D 中并在 3D 空间中进行跟踪。 |

摘要

在视频中恢复密集且长距离的像素运动是一个具有挑战性的问题。部分困难源于三维到二维的投影过程,这会导致二维运动域中出现遮挡和不连续现象。尽管二维运动可能非常复杂,但我们认为,其背后的三维运动通常较为简单且维度较低。

在本研究中,我们提出通过估计三维空间中的点轨迹来缓解由图像投影带来的问题。我们的方法名为 SpatialTracker,它利用单目深度估计器将二维像素提升至三维空间,采用三平面(triplane)表示法高效地表达每一帧的三维内容,并通过 Transformer 进行迭代更新,以估计三维轨迹。在三维空间中进行跟踪使我们能够引入“尽可能刚性”(as rigid-as-possible, ARAP)的约束,同时学习一种刚性嵌入(rigidity embedding),将像素聚类为不同的刚性部分。大量实验评估表明,我们的方法在定性和定量方面均达到了最先进的跟踪性能,尤其在平面外旋转等具有挑战性的场景中表现突出。

引言

- 任务大定义:运动估计历来主要通过两种范式来实现:特征跟踪 和 光流法:光流只能生成相邻帧之间的运动,而特征跟踪仅能追踪稀疏的像素点。

- 任务小定义:理想的解决方案应能够同时估计视频序列中密集且长距离的像素轨迹 。近年来,一些研究重新关注这一问题,将其表述为“任意点跟踪”任务,并通过监督学习框架加以解决。尽管这些方法仅在合成数据集上训练,但它们在真实世界视频中展现出强大的泛化能力

- 之前的方法为什么不行:在伴随频繁自遮挡的复杂形变情况下仍面临挑战,我们认为,造成这一困难的一个潜在原因在于仅在二维图像空间中进行跟踪,从而忽略了运动本身固有的三维本质。

- 运动实际发生在三维空间中,某些特性只能通过三维表示才能充分表达。

- 此外,使用二维特征相关性来预测运动更新也存在局限性。图像投影可能将三维空间中相距较远的区域在二维图像中变得邻近,导致用于相关性的局部二维邻域可能包含无关上下文(特别是在遮挡边界附近),从而影响模型的推理能力。

- 我们的方法是: 提出利用当前最先进的单目深度估计器 提供的几何先验,将二维像素提升至三维空间,并在三维空间中进行跟踪。这包括在三维空间中进行特征相关计算,从而为复杂运动情况下的跟踪提供更有意义的三维上下文信息。在三维空间中跟踪还允许我们引入三维运动先验 [52, 63],例如“尽可能刚性”(ARAP)约束。鼓励模型学习哪些点以相同刚体方式运动,有助于跟踪模糊或被遮挡的像素,因为这些像素的运动可以通过同一刚体组内未被遮挡且可见的邻近区域推断出来。

- 具体而言:我们提出使用三平面特征图(triplane feature maps)来表示每一帧的三维场景

- 该表示首先将图像特征提升为三维特征点云,然后将其“点阵化”(splatting)到三个正交平面上获得。三平面表示紧凑且规则,适用于我们的学习框架。更重要的是,它对三维空间进行了稠密覆盖,使我们能够提取任意三维点的特征向量用于跟踪。

- 随后,我们通过基于三平面表示的特征,利用 Transformer 预测迭代更新,计算查询像素的三维轨迹。

- 为了利用三维运动先验对估计的三维轨迹进行正则化,我们的模型还为每条轨迹预测一个刚性嵌入(rigidity embedding),从而对具有相同刚体运动的像素进行软聚类,并对每个刚性簇施加 ARAP 正则化。我们证明,该刚性嵌入可以以自监督方式学习,并合理地分割出不同的刚性部分。

创新点

相关工作

Optical flow.

估计一对帧之间密集的二维像素级运动的任务。

- 传统方法将其视为能量最小化问题来处理,

- 而近年来的研究则展示了使用深度神经网络直接预测光流的能力。特别是,RAFT使用一个四维相关体积,并通过递归操作符迭代更新来估计光流。

- 最近,基于Transformer的流估计器达到了更优性能。

然而,成对的光流方法不适合长期跟踪,因为它们未设计用于处理长时间上下文

多帧光流方法

扩展了成对光流,但这对于跨越数十或数百帧视频中的长遮挡跟踪仍然不足。

Tracking any point.

跟踪任意点 - 开创性工作 Particle Video提出将视频运动表示为一组随时间移动的长距离粒子,并通过变分技术强制执行长范围外观一致性和运动一致性来优化这些粒子。然而,Particle Video 仅生成半稠密轨迹且无法从遮挡事件中恢复。

- 最近,PIPs 通过引入一个前馈网络重新审视了这一想法,该网络以固定时间窗口(8帧)的RGB帧作为输入,并通过迭代更新预测给定查询点的运动。然而,PIPs 独立地跟踪点,忽略了空间上下文信息,并且如果目标在时间窗口之外保持被遮挡,则会丢失目标。

- 为了解决了PIPs的一些局限性。TAPIR [12] 通过使用能够适应可变长度的时间深度卷积网络放松了固定长度窗口约束。CoTracker [29] 提出了联合跟踪多个点并利用它们之间的空间相关性的方法,从而达到了最先进的性能。尽管取得了显著进步,但这些工作都在二维图像空间中计算特征相关性,丢失了关于实际发生运动的三维场景的重要信息。

**Scene flow. **

场景流定义了一个场景中点的密集三维运动场。这个就不看了,一个是stereo输入,一个是点云输入,这两种方法,场景流估计也是非刚性重建管道中的一个子任务。

方法

概述

给定单目视频作为输入,跟踪整个视频中的任何给定查询像素。首先将每个框架的外观和几何信息编码为三平面表示(第 3.1 节)。然后,我们使用这些三平面表示以滑动窗口方式对 3D 空间中的轨迹进行迭代预测(第 3.2 节)。我们在训练期间利用尽可能刚性 (ARAP) 3D 运动来促进跟踪。

3.1. Triplane Encoding of Input Video Frames

- 对于每一帧,使用预训练的单目深度估计器获得其单目深度图。

- 同时,通过卷积神经网络(CNN)生成多尺度特征映射。

- 随后,2D 像素被投影到一组 3D 点云中,其中每个 3D 点都与一个特征向量相关联。该特征向量是相应图像特征及其 3D 位置的位置嵌入的contact。

- 不用3dcnn,为了密集、高效地获得三维特征,我们建议使用三平面特征图,该图是通过将特征点云正交投影和平均投影到三个正交的二维平面上获得的。

- 最后应用额外的卷积层来处理和完成每个特征图。此三平面特征编码过程应用于每个视频帧。

- 将点投影到三个特征平面上,通过双线性插值提取其对应的特征向量,并通过简单的加法将它们融合。

3.2. Iterative Trajectory Prediction

给定查询帧中的一组查询像素,获得它们的 3D 位置和相应的三平面特征。

按照 CoTracke,将视频划分为长度为 T 的重叠窗口。在每个窗口中使用transformer迭代估计 M 步查询点的 3D 轨迹。然后,最终的 3D 轨迹被传播到下一个窗口并更新,这个过程一直持续到视频结束。

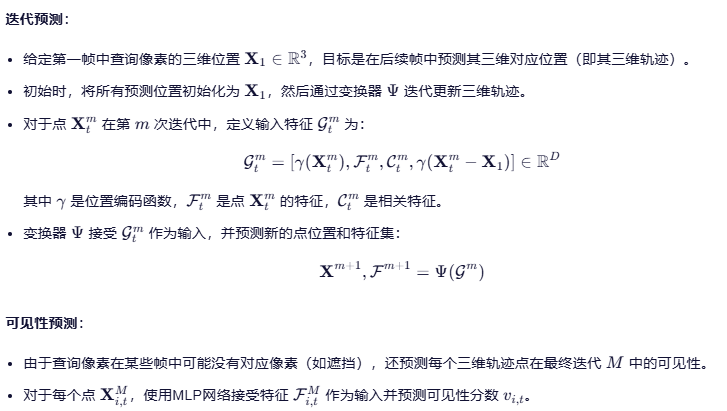

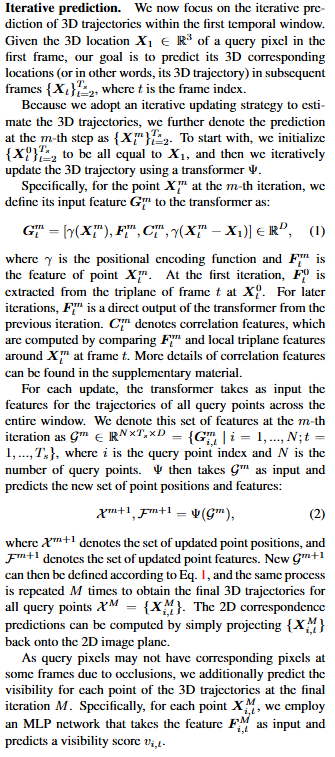

Iterative prediction. :

现在专注于第一个时间窗口内 3D 轨迹的迭代预测。给定第一帧中查询像素的 3D 位置预测其在后续帧中的 3D 对应位置。

Handling long videos. :

使用重叠的滑动窗口,其中每对相邻窗口的一半帧重叠。给定上一个窗口的结果,我们通过从前一个窗口复制最后一帧的结果来初始化当前窗口第一帧的轨迹。当前窗口中最后一帧的轨迹是通过复制帧的结果来初始化的。

3.3. As Rigid As Possible Constraint

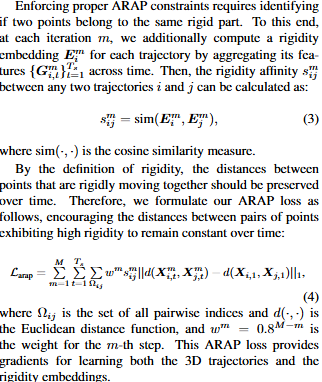

计算跟踪点和其他跟踪点是不是在同一个刚体上,如果在,那么在帧间,两个跟踪点的三维距离不会发生太大变化,增加一个损失鼓励跟踪点距离不变化。

3D 跟踪点的一个优点是我们可以强制执行尽可能刚性 (ARAP) 约束,这增强了空间一致性并有助于预测运动,尤其是在遮挡期间。要实施适当的 ARAP 约束,需要确定两个点是否属于同一刚性零件。为此,在每次迭代 m 中,我们还通过聚合其特征 {G} (通过光谱聚类来获得查询像素的分割计算获得)来计算每个轨迹的刚度嵌入 E。然后,任意两个轨迹 i 和 j 之间的刚性亲和力 s 可以计算出来。

据刚度的定义,刚性一起移动的点之间的距离应随着时间的推移而保持。因此,我们将 ARAP 损耗公式化如下,鼓励表现出高刚性的点对之间的距离随时间保持恒定。