论文阅读_ET-MVSNet

ETMVSNet

基本信息

| 项目 | 内容 |

|---|---|

| 论文标题 | ET-MVSNet (Epipolar Transformer Multi-View Stereo Network) |

| 作者 | Tianqi Liu, Xinyi Ye, Weiyue Zhao, Zhiyu Pan, Min Shi*, Zhiguo Cao |

| 作者单位 | 华中科技大学人工智能与自动化学院 |

| 时间 | 2023 |

| 发表会议/期刊 | ICCV |

方法概览

| 特点 | 文章性质 |

|---|---|

| 输入 | 多视角 |

| 输出 | 参考视角深度图 |

| 所属领域 | MVS |

1. 摘要精简

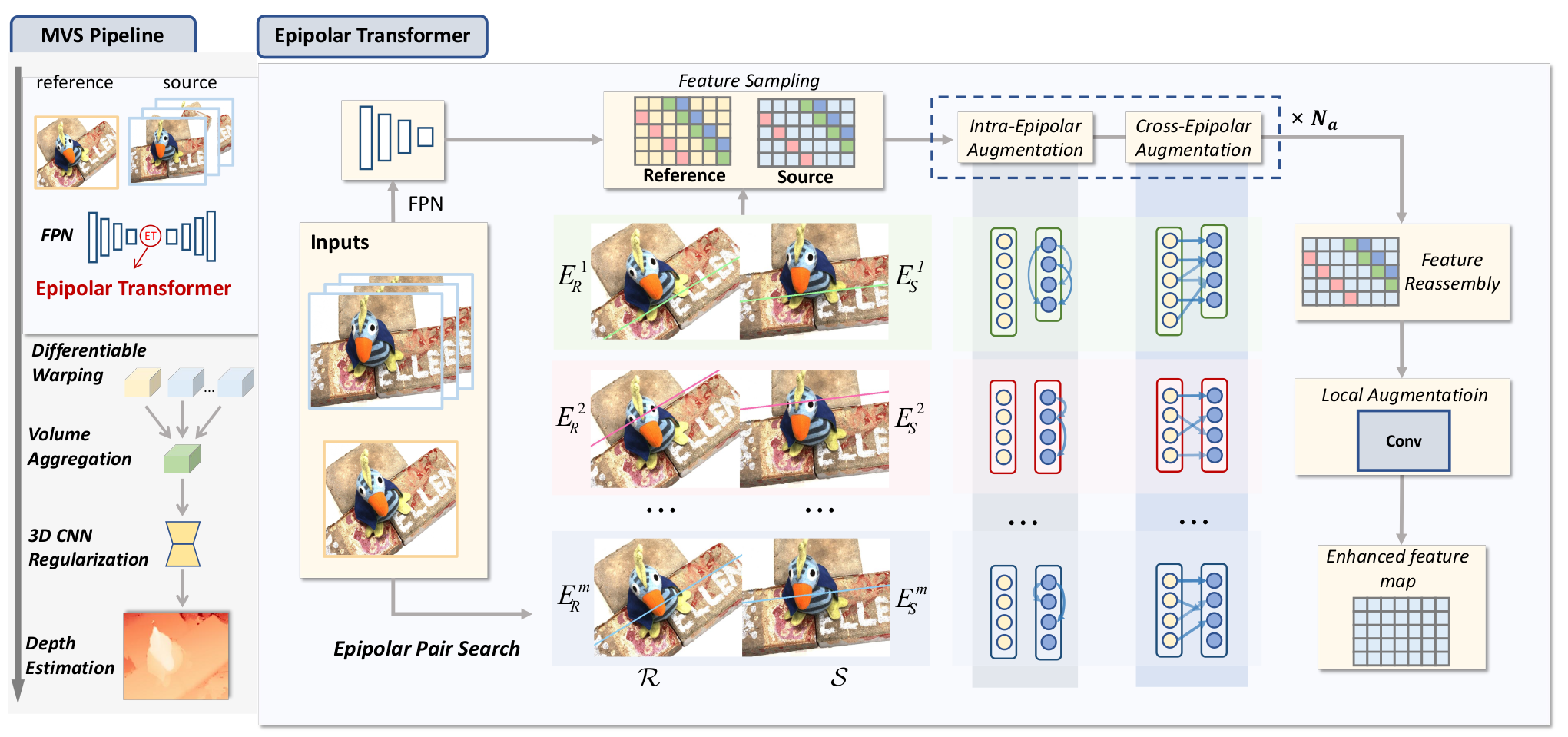

本文提出 ET-MVSNet,一种基于极线约束与非局部算子融合的多视图立体(MVS)方法。核心创新是将非局部特征聚合限制在极线对范围内,而非全图,大幅降低计算开销。具体通过优化的极线对搜索算法拆分特征图,设计极线 Transformer(ET)模块,包含极线内增强(IEA)和极线间增强(CEA),实现高效非局部特征聚合,辅以局部增强模块修复特征不连续性。该方法在 DTU 和 Tanks&Temples 基准上实现 SOTA 重建性能,同时保持高计算效率,且 ET 模块可作为即插即用组件集成到其他 MVS 框架中。

就是把特征图单独使用基线拿出来,然后在基线上算注意力,把这个注意力再融合到特征图中,分为这个基线自己内部做attention,然后基线对两个之间做attention,最后变成一个HW的特征图,把这个和FPN特征图融合到一起,后面还是要做代价体

2. 研究动机与出发点

- 问题:特征匹配依赖非局部信息,但传统非局部算子(如 Transformer、可变形卷积)需每个像素关注全图,计算开销巨大,且易引入无关特征干扰;现有的非局部特征增强方法(如Transformer)计算开销大,每个像素需要密集关注整个图像

- 洞察:根据极线几何,一个点在不同深度假设下会投影到另一视图的极线上

- 解决方案:将2D搜索空间缩减为极线,提出点对线的非局部增强策略

3. 创新点

3.1 极线对搜索算法

提出优化的搜索算法,将2D特征图分割成极线对:

极线参数计算:

对于参考图像中的像素,在源图像中的对应像素为:

极线方程:

通过消除深度得到标准极线方程:

其中:

量化分组:为避免过分割,对和进行取整量化,将参数相近的像素分组到同一极线。我们得到m对极线,每对极线包括参考图像上的一个极线序列和源图像上的一个极线序列,每个序列的形状为,n是序列中像素的数量,c是特征维度。按极线参数在源图中匹配对应极线(通过像素到极线的距离判断),形成极线对和。

3.2 极线Transformer(ET)

ET 模块可无缝集成到现有 MVS 框架(如 CasMVSNet、MVSTER)的 FPN 中,无需大幅修改网络结构,即可显著提升性能,兼容性强。包含三个核心模块:

极线内增强(IEA):

在极线内部使用自注意力聚合非局部结构信息:

E^i_S = \text{MHSA}(E^i_S) + E^i_S, MHSA是多头自注意力(Multi-Head Self-Attention),与标准Transformer中的自注意力相同。$$注意:在CEA之后,论文还使用了一个前馈网络(FFN),但公式中未明确写出,实际上在代码实现中应该包含。 **跨极线增强(CEA)**: 使用交叉注意力在极线对间传递信息: $$E^i_S = \text{MHCA}(E^i_S, E^i_R, E^i_R) + E^i_S. MHCA是多头交叉注意力(Multi-Head Cross-Attention)

局部增强(LA):

由于极线搜索和序列化可能造成特征图的不连续(空洞),因此使用一个卷积层来重新聚合局部上下文,填补空洞并平滑特征。

LA模块就是一个卷积层,对增强后的特征图进行卷积处理。

3.3 线对点特征聚合策略

- 传统:点对全局(计算开销大)

- ET-MVSNet:线对点(基于极线约束,高效且有效)

4. 网络架构

ET-MVSNet 基于粗到精框架(4 个阶段),核心分为五大模块,流程为 “特征提取→极线对搜索→ET 增强→代价体处理→深度生成”:

- 特征提取模块:FPN 网络提取多尺度特征,分辨率从 1/8 到 1×;

- 极线对搜索模块:拆分特征图为极线对集群;

- ET 增强模块:IEA+CEA+LA 增强最粗尺度特征,在FPN的最粗特征图(下采样率8)上集成Epipolar Transformer;

- 代价体处理模块:逆深度采样、特征 warping、多视图聚合、3D CNN 正则化;

- 深度生成模块:从概率体回归深度,多阶段逐步细化。8, 8, 4, 4(四个阶段)

5. 特征提取

- 使用**特征金字塔网络(FPN)**提取多尺度特征,通道数随尺度提升而增加;

- 选取最粗尺度(1/8 分辨率)特征应用 ET 模块:该尺度特征感受野大、计算成本低,适合非局部聚合;

- ET 增强后的特征经 FPN 上采样模块恢复至各尺度,与原始 FPN 特征融合,为代价体构建提供强判别性特征。

6. 代价体构建

- 深度假设采样:采用逆深度采样,4 个阶段的深度假设数分别为 8、8、4、4,后一阶段基于前一阶段深度结果缩小采样范围;

- 采用自适应加权策略融合多源视图的 warped 特征体积

- 测量相似度并聚合得到3D代价体

7. 代价体正则化

- 使用3D CNN对代价体进行正则化

- 输出每个深度假设的概率体积

8. 深度图生成

从正则化后的概率体积推断深度,采用动态一致性检查策略进行深度过滤和融合

9. 损失函数

总损失采用交叉熵损失优化各阶段深度预测,基于概率体与真值 one-hot 编码计算;,总损失为多阶段损失的加权和:

其中:

- (四个阶段)

- 超参数设置:,赋予细阶段更高权重,优先优化高精度深度。

- 每个阶段使用交叉熵损失

10. 测试数据集

- DTU:室内数据集,128个场景,固定相机轨迹

- Tanks and Temples:室外真实场景,包含中级(8场景)和高级(6场景)子集

- BlendedMVS:用于在Tanks and Temples上评估前的微调

11. 消融实验

消融实验基于 DTU 数据集,验证核心组件有效性:

- ET 模块组件:测试 IEA、CEA、LA 的单独作用与组合效果,验证三者协同能实现最优的深度误差和重建质量;

- 极线搜索算法:对比 “line-to-line(预聚类极线对)” 与 “point-to-line(逐像素计算极线)”,验证前者在保持性能的同时,计算量降低 50 倍、推理速度提升 6 倍;

- 特征聚合方法:对比 ET 与 FMT(Feature Matching Transformer)、DCN(可变形卷积)、ASPP,验证 ET 在参数最少的情况下,深度误差和重建质量最优;

- 兼容性测试:将 ET 集成到 CasMVSNet,DTU 总体误差提升 15%,Tanks&Temples Intermediate/Advanced 集分别提升 8%/15%,验证其即插即用特性。

11.1 ET组件有效性

- 基线:Overall 0.318, Depth Error 6.355

- +IEA+CEA:Overall 0.297, Depth Error 5.843(提升6%)

- +IEA+CEA+LA:Overall 0.291, Depth Error 5.754(最佳性能)

11.2 极线搜索算法比较

- 点对线:Overall 0.290, MACs 25.66G, 时间3.06s

- 线对线:Overall 0.291, MACs 0.586G, 时间0.46s(效率提升显著)

11.3 特征增强方法比较

- ET:Overall 0.291, 参数1.09M(最优)

- FMT:Overall 0.303, 参数1.42M

- DCN:Overall 0.309, 参数1.20M

- ASPP:Overall 0.320, 参数1.26M

11.4 兼容性实验

在CasMVSNet上集成ET:

- DTU:Overall从0.355提升到0.301(提升15%)

- Tanks&Temples中级:从56.84提升到61.62(提升8%)

- Tanks&Temples高级:从31.12提升到35.65(提升15%)

实验结果

- DTU:Overall 0.291mm,排名第一

- Tanks&Temples中级:65.49 F-score,排名第一

- Tanks&Temples高级:40.41 F-score,排名第一

- 在弱纹理和重复图案区域表现尤其优秀

总结

ET-MVSNet通过将极线几何约束与非局部特征增强相结合,实现了高效且准确的MVS重建。其核心创新在于将全局注意力缩减为极线注意力,在保持性能的同时大幅提升效率,并且可以作为即插即用模块集成到其他MVS框架中。