论文阅读_ControlNet

ControlNet:Adding Conditional Control to Text-to-Image Diffusion Models

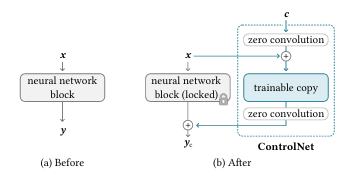

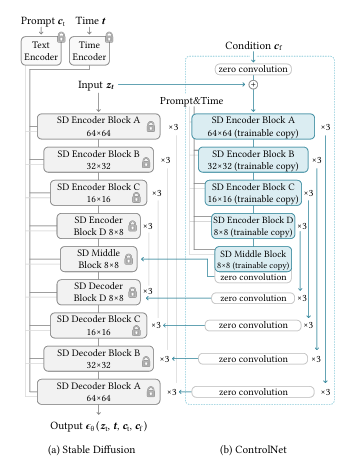

ControlNet,这是一种端到端神经网络架构,用于学习大型预训练文本到图像扩散模型的条件控制(在我们的实现中为 Stable Diffusion)。ControlNet 通过锁定大型模型的参数,并创建其编码层的可训练副本,来保留大型模型的质量和功能。此架构将大型预训练模型视为学习各种条件控制的强大支柱。可训练副本和原始锁定模型与零卷积层连接,权重初始化为零,以便它们在训练期间逐渐增长。这种架构确保在训练开始时不会将有害的噪声添加到大型扩散模型的深层特征中,并保护可训练副本中的大规模预训练主干免受此类噪声的损害。

问题:

- 使用学习条件控制稳定扩散。

背景:

- 在开源社区已经形成以Stable Difffusion为核心,以ConrtolNet和LoRA为辅助模块的AI绘画工作流生态,controlnet让AI绘画的生成过程更加的可控

步骤:

-

使用ControlNet模型之后,Stable Diffusion模型的权重被复制出两个相同的部分,分别是“锁定”副本(locked)和“可训练”副本。其中“锁定”副本中的权重保持不变,保留了Stable Diffusion模型原本的能力;与此同时,使用额外数据对“可训练”副本进行微调,学习我们想要添加的条件。

-

ControlNet模型的最小单元结构中有两个zero convolution模块,它们是1×1卷积,并且权重和偏置都初始化为零。这样一来,在我们开始训练ControlNet之前,所有zero convolution模块的输出都为零,使得ControlNet完完全全就在原有Stable Diffusion底模型的能力上进行微调训练,

工业应用示例:

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来源 This is a 部落格 of outbreak_sen!